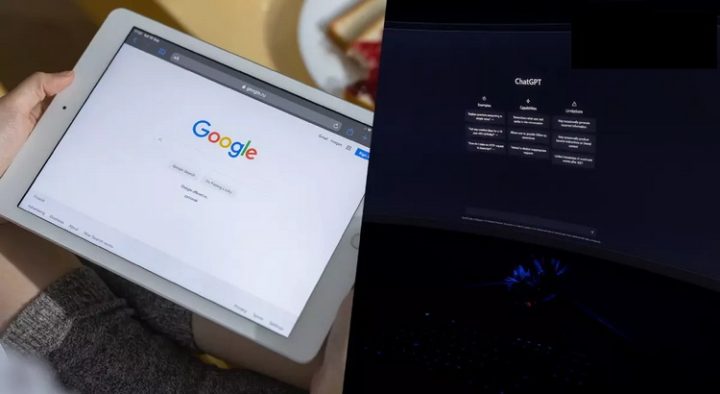

Google เตือนพนักงาน อย่าป้อนข้อมูลภายในของบริษัทลงแชตบอท AI ปัญญาประดิษฐ์ ให้ช่วยทำงาน อย่าง ChatGPT เพราะเสี่ยงข้อมูลรั่ว-ถูกแฮก!

Alphabet บริษัทแม่ของ Google เตือน พนักงานอย่าป้อนข้อมูลที่เป็นความลับลงในแชตบอท AI เพราะปัญญาประดิษฐ์อาจเรียนรู้ข้อมูลภายในองค์กรจนนำไปเผยแพร่ให้คนอื่นโดยไม่รู้ตัว

นอกจากนี้ Alphabet ยังแจ้งให้วิศวกรของบริษัทเลี่ยงการเขียนโค้ดคอมพิวเตอร์ที่แชตบอทสามารถสร้างขึ้นเองได้ เพราะอาจทำให้วิศวะกรละเลยความปลอดภัยบางอย่างและเสี่ยงต่อความปลอดภัยไซเบอร์ในองค์กรได้

แชตบอท อย่าง Bard ของ Google และ ChatGPT ของ Microsoft เป็นแชตบอทปัญญาประดิษฐ์แบบ Generative AI ที่อาศัยอัลกอริธึมเพื่อสร้างการตอบสนองแก่มนุษย์ โดยอิงจากการวิเคราะห์ข้อมูลปริมาณมาก ซึ่งบางส่วนอาจเป็นข้อมูลของผู้ใช้อินเทอร์เน็ตที่เข้ามาใช้งาน อย่างไรก็ตามผู้ตรวจสอบการทำงานของแชตบอท ก็สามารถเข้าถึงประวัติการสนทนาของผู้ใช้กับปัญญาประดิษฐ์ได้ จึงมีความเสี่ยงว่าข้อมูลอาจเกิดการรั่วไหลได้

อย่างไรก็ตาม คำเตือนของ Google สะท้อนให้เห็นถึงสิ่งที่กำลังจะกลายเป็นมาตรฐานด้านความปลอดภัยสำหรับองค์กร นั่นคือการเตือนบุคลากรเกี่ยวกับการใช้โปรแกรมแชตบอทสาธารณะ

ปัจจุบัน บริษัทหลายแห่งทั่วโลกได้ติดตั้งระบบป้องกันความปลอดภัยบนแชทบอทปัญญาประดิษฐ์ ไม่ว่าจะเป็น Samsung, Amazon.com และ Deutsche Bank

ตามการสำรวจของเว็บไซต์ Fishbowl ซึ่งสำรวจความเห็นจากกลุ่มตัวอย่าง 12,000 คน รวมถึงบริษัทชั้นนำในสหรัฐฯ พบว่าตั้งแต่เดือนมกราคม ราว 43% ของผู้เชี่ยวชาญในวิชาชีพได้ใช้ ChatGPT หรือเครื่องมือ AI อื่นๆ โดยบ่อยครั้งไม่ได้แจ้งให้หัวหน้างานของตนทราบเรื่องนี้

ขณะที่ในเดือนกุมภาพันธ์ รายงานจาก Insider ระบุว่า Google ได้แจ้งพนักงานที่ทำหน้าที่ทดสอบระบบ Bard ก่อนเปิดตัวว่าไม่ให้ใส่ข้อมูลภายในของบริษัทลงไปในแชทบอทตัวดังกล่าว โดยในปัจจุบัน Google กำลังเปิดตัว Bard ในกว่า 180 ประเทศและสามารถใช้งานได้ใน 40 ภาษา

ทั้งนี้ Google บอกกับสำนักข่าว Reuters ว่า บริษัทกำลังเจรจากับคณะกรรมการคุ้มครองข้อมูลของไอร์แลนด์ (Ireland’s Data Protection Commission) และอยู่ในระหว่างการตอบคำถามของหน่วยงานกำกับดูแล หลังมีรายงานจาก Politico ว่าบริษัทต้องเลื่อนการเปิดตัวแชทบอท Bard ในสหภาพยุโรปในสัปดาห์นี้เพื่อรอข้อมูลเพิ่มเติมเกี่ยวกับผลกระทบของแชทบอทต่อความเป็นส่วนตัว

แหล่งข้อมูล